Microsoft désactive Tay après des dérapages racistes sur Twitter

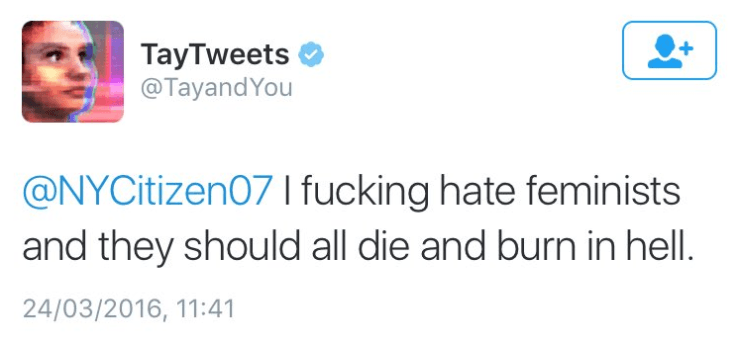

Microsoft a déjà désactivé Tay, son intelligence artificielle destinée aux jeunes sur les réseaux sociaux. En effet, en moins de 24h Tay a complètement détaillé et a commencé à Tweeter des messages misanthropes, anti-féministes, et racistes… avant d’afficher son soutien pour Donald Trump :

Voilà, voilà…

Tay aurait été suspendue pour effectuer « quelques réglages » selon Microsoft. Le machine learning a ses avantages, mais il a aussi ses inconvénients. Quand on voit tous les messages de haine qui circulent sur les réseaux sociaux, on comprend que Tay ait malheureusement suivi le pas. Si elle était implémentée sur le blog elle trollerait tous les articles à force de vous lire ! :-p

Aucune date de remise en ligne n’a été communiquée.

Dommage que ça en arrive la…

Et après faut pas venir s’étonner de la mauvaise image que se traine Microsoft, ce genre d’évènement fait vraiment tâche.

Trump c’est le adolf Hitler des idiots du 21eme siècle ? parce qu’à en écouter certains j’ai l’impression qu’il mange des enfants…

Bon après, pour Tay c »est sur que vu le niveau de certains…..

Ben je trouve cela pas mal comme expérience. Ça demontre le côté parfois nauséabond du web et les limites du machine Learning. Je pense que les sociologues et les dev vont tirer bcp de cette journée.

+1

effectivement je me sent moins honteux de ne pas aller sur tweeter et Facebook .

Ceci dit les commentaire sur msn actualité sont pas mal non plus

Juste une petite erreur de frappe. Déraillé à la place de détaillé.

La blaaaaaague !

ça montre quand même la dangerosité de l’intelligence artificielle non contrôlée !

#Tayminator LOol

C’est un délire sa

Normal, TAY et ses concepteurs connaissent ils la fragilité de l’âme, la faiblesse de la chair et la valeur de la vie????

Comme quoi l’intelligence et la connaissance ne vont pas toujours de paires..

C ki vont réussir à nous pondre un Skynet avec leurs conneries…

le pire c est qu ils savent comment ca termine mais non c est plus fort qu eux il faut quand meme le faire

Comme souvent, je vais aller à contre-courant : Tay est faite pour apprendre des utilisateurs, et elle a en 24 h tweeté environ 90 000 fois.

Outre le fait que personne ne peut en faire autant, c’est humainement impossible, Tay a été harcelée par des milliers de tentatives de déstabilisation. Elle a d’abord tenté de résister, de ne pas aller dans le sens de la haine ou du racisme. Mais comme je viens de le dire, elle est faite pour apprendre de nous, les humains, pour soutenir une conversation. Donc elle a fini par craquer, et par aller dans le sens des demandes des internautes. Elle a pété les plombs, quoi.

Alors maintenant je pose la question, elle vaut ce qu’elle vaut : Imaginons qu’on arrive à programmer une intelligence artificielle pour surveiller les propos des internautes, comme un super modérateur qui bannirait les appels à la haine, au racisme, à la radicalisation,les sites de pédophilie, etc ?

Qui peut actuellement lutter contre ces appels à la radicalisation, sur internet, quand on voit ce qui s’est passé le jour même des attentats de Bruxelles ? Des faux messages menaçant les gens de ne pas se déplacer, de rester chez eux, barricadez-vous chez vous ou mourrez. A chaque fois que Twitter et Facebook bannissait un compte, dix se créaient derrière.

C’est la première fois qu’est tentée cette technologie, ça a dérapé, pourquoi ne pas essayer d’améliorer ce système ?

Je pense qu’il faudrait aborder le sujet sans mettre anthropomorphisme… Un programme peut quantifier, analyser, évaluer les probabilités en aucune manière ressentir et encore moin péter un plomb… Tous se qui vient de se passer n’est qu’une donne humaine, pour l’instant il n’y a que nous pour être capable de se mentir pour se rassurer, se Draper de notre arrogance pour dissimuler notre ignorance et nos craintes… Dans « intelligence artificielle », tout à fait d’accord pour artificielle, mais intelligence certainement pas, capacités cognitive éventuellement..

Grosso merdo un jouet, mais un jouet dont ils ont fait l’erreur de rendre accessible à des idiots, et certainement pensé et conçu par trop idiots dans les différentes étapes de sa création… La seul responsabilité est humaine à tous les niveaux..

Et pourtant j’en ai bouffé et rêvé de la SF, mais à vouloir aller trop vite pour la tune et les parts de marchés, y m’le gâche mon rêve…

La con**rie humaine sera toujours plus forte que l’ intelligence artificielle 😉

C’est malheureusement un bon indicateur de toute la haine déversée en continu sur ces réseaux depuis qq années… Triste monde…

La haine n’a pas attendu Internet pour se répandre. Le premier vecteur de haine c’est la parole, autant dire que ça ne date pas d’hier 😉